AI作為引領新一輪科技革命和產業變革的戰略性技術,正成為發展新質生產力的重要引擎。預計未來兩年,AI大模型將落地50%+行業場景,引領廣泛的智能化革命。數據作為AI產業鏈的基礎要素,其規模與質量直接決定了AI智算的廣度與深度。

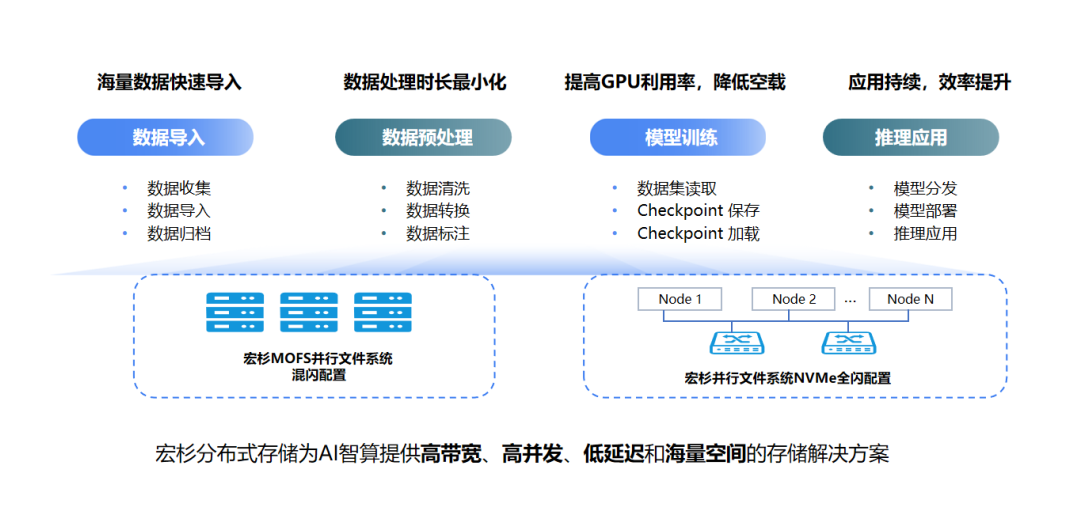

在AI大模型的全生命周期中,包含4個關鍵環節:

- 數據歸集:數據採集方式多樣,需兼容NFS、SMB、S3等多種存儲協議,構建超大容量、靈活適應的“數據倉庫”。

- 數據預處理:針對數據在此階段的複雜性與無序性,需構建可靈活應對混合IO負載與多變讀寫模式的存儲架構。

- 模型訓練:需高效加載數據至GPU進行計算,對存儲性能有嚴格要求(高IOPS、高帶寬、低延遲),以確保訓練過程的流暢與高效。

- 推理應用:需快速加載海量模型文件,單個文件大小在幾十GB至上百GB不等。若同時啟動數十個推理業務,整體數據量將達幾十至上百TB,對讀取效率提出較高要求。

在整個流程中,模型訓練是最重要的一環,對存儲系統性能要求極高。為確保訓練任務如期完成,實現訓練數據快速加載、GPU無等待、Checkpoint(AI大模型訓練過程中定期保存的模型狀態快照)快速保存與恢復的目標,通常需要存儲系統提供數百GB/s的帶寬,以及千萬級的IOPS處理能力。

以自然語言處理(NLP)在大型預訓練語言模型GPT3中的Checkpoint保存場景為例,175B的參數規模,其Checkpoint文件達3TB左右,若要在30s內完成Checkpoint文件的保存,其寫帶寬需達到100GB/s。為此,亟需構建高性能、高可擴展性的數據存儲底座,以支撐AI大模型的核心業務流程。

憑藉在數據存儲領域十餘年的創新與積澱,宏杉科技精耕細作,以MC27000-MOFS高性能分布式並行存儲系統與MacroDisk智能盤櫃為核心,打造智算中心AI存儲解決方案,為AI大模型的精研之路奠定堅實基礎。該產品採用INTEL Xeon 6430處理器,以滿足客戶的高性價比要求。它們為最終客戶提供高級功能,例如“熱數據和冷數據的分層存儲”和災難恢復等數據中心服務。

MC27000-MOFS高性能分布式並行存儲提供高效運行引擎:

數據歸集和預處理階段,MOFS系統可構建基於傳統HDD硬盤的海量數據資源池,支持NFS/CIFS/HDFS協議互訪與多節點並發讀寫,極大地加速了數據的導入與處理。其單集群單文件系統容量可達1000PB,文件數量達千億級,充分滿足AI智算對海量數據的處理需求。

在模型訓練和推理階段,MOFS系統可提供全NVMe介質的高性能資源池,通過部署增強型客戶端,並融合客戶端切片、MPI-IO、RDMA網絡、小文件聚合等先進技術,系統單節點混合讀寫性能可達30GB/s以上,實現了數據的高效處理與流暢傳輸。

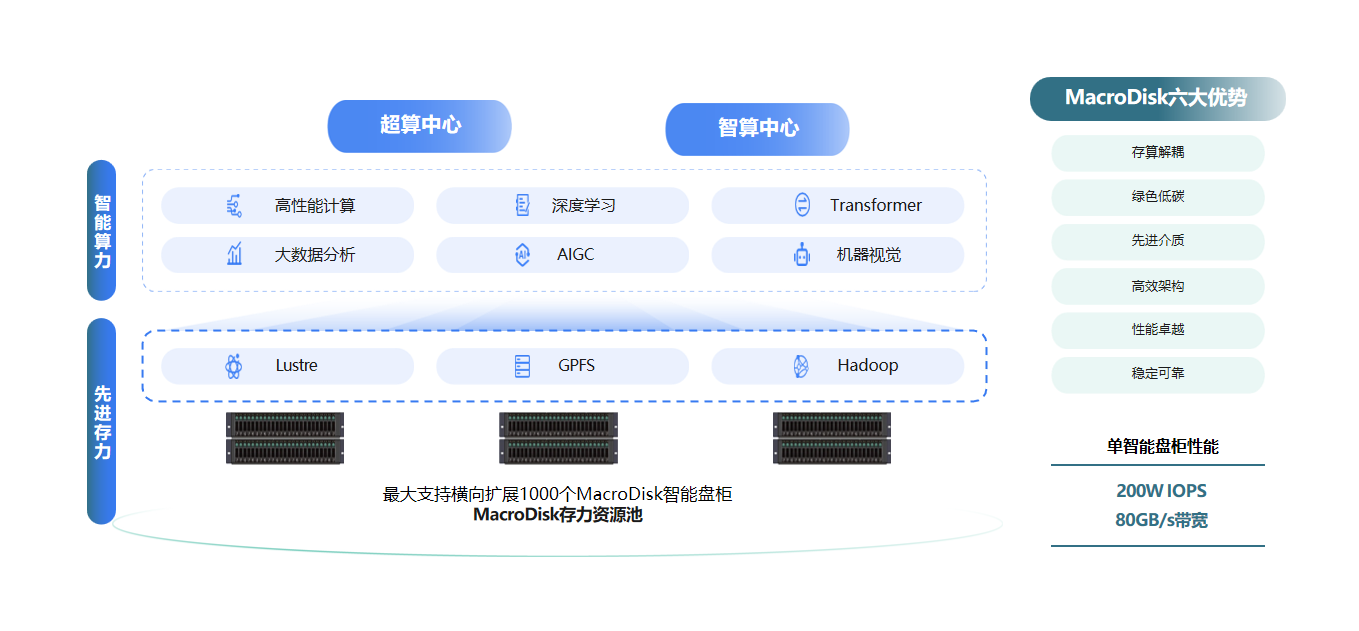

MacroDisk智能盤櫃打造穩定存儲底座:

當前,Lustre/GPFS等並行文件系統已被廣泛應用於AI訓練流程之中,成為驅動AI智算發展的關鍵力量。然而,Lustre的多個數據存儲單元(OSS)並未自帶數據保護功能,當一個客戶端或節點發生故障時,其中的數據在重新啟動前將不可訪問。因此,存算分離是此架構下提升系統整體可靠性的關鍵路徑。

在Lustre/GPFS並行文件系統+集中式存儲的整體架構下,宏杉科技以MacroDisk智能盤櫃為關鍵硬體支撐,面向HPC、AI等場景,無縫對接客戶Lustre/GPFS等原有並行文件系統,為AI訓練構建了極致性能、極致可靠的存儲資源池。

MacroDisk支持NVMe over ROCE+INOF、NVMe over FC兩種高速數據傳輸方式,單套設備即可提供200W IOPS、80GB/s帶寬;採用雙控制器Active-Active架構,確保數據的高效讀寫及訪問;集成磁盤監測、慢盤檢測、磁盤診斷等功能,實現對磁盤健康狀況的實時監控與精準維護;引入CRAID3.0技術,採用22+3或者23+2的比例進行數據硬盤和校驗硬盤的配置,在保障數據安全的同時,實現高達92%的空間利用率,為AI智算中心的穩定運行與未來發展提供了強有力的支撐。

隨著國家政策的持續推動與技術趨勢的加速演進,AI智算正邁向更加高效、智能、安全的新紀元。作為一站式數據存儲專家,宏杉科技將緊跟行業發展脈搏,以數賦智,用更多前沿創新方案助力AI產業“新藍海”的開拓。

評論